介绍

方法

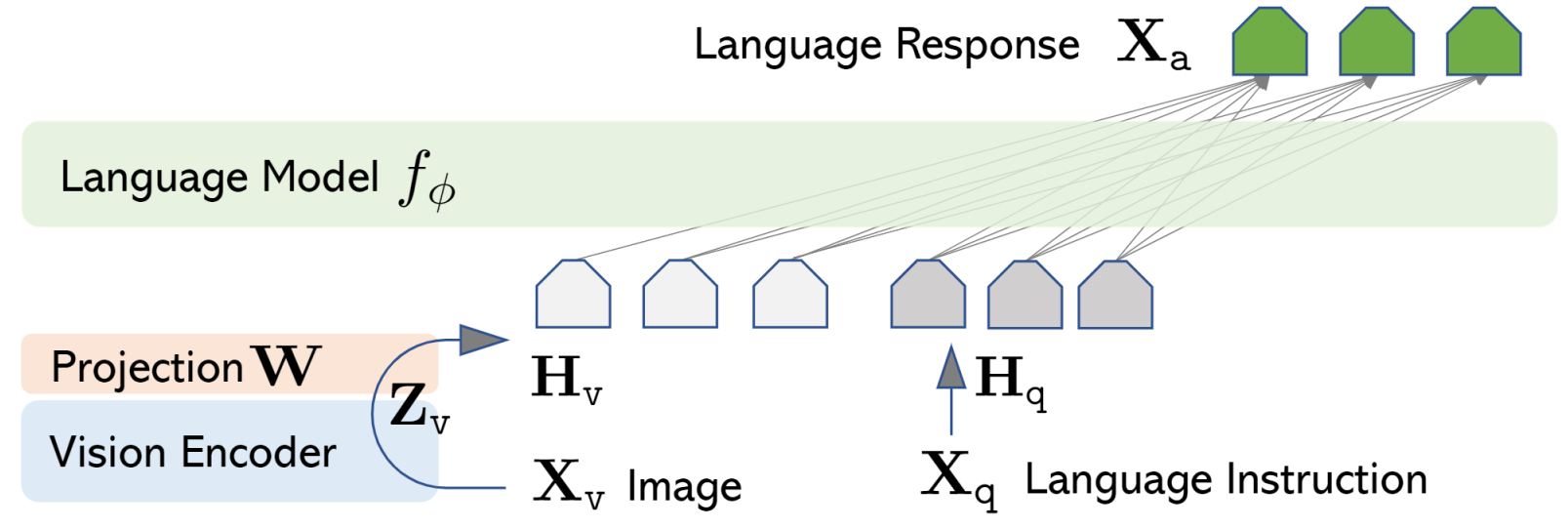

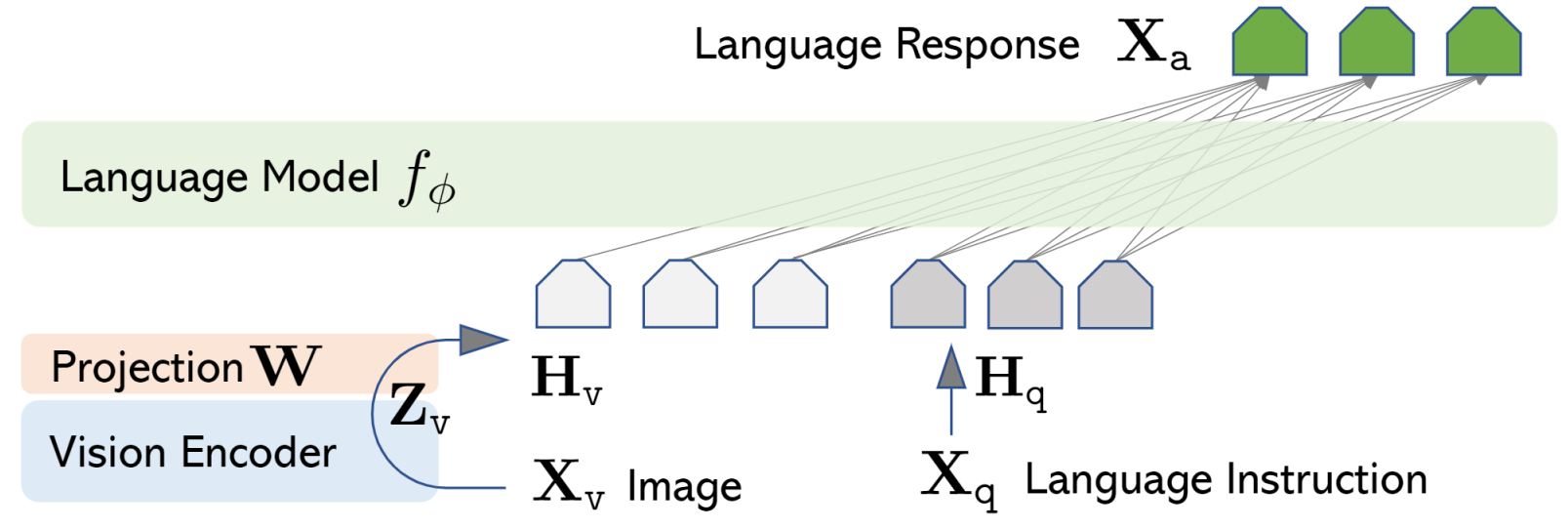

一分钟了解一片论文系列,从框架图可以看出网络设计相对简洁,图像经过 Vision-encoder(比如 CLIP)之后,经过一个 MLP 将特征转换为文本空间,然后与文本 prompt 拼接后输入 LLM 模型用于文本训练。文章中提到对于视觉特征到文本特征的转换方式可以使用 Blip 中的 Q-former 进一步提升效果。

应用

思考

参考文献

- Project Page: https://llava-vl.github.io/

一分钟了解一片论文系列,从框架图可以看出网络设计相对简洁,图像经过 Vision-encoder(比如 CLIP)之后,经过一个 MLP 将特征转换为文本空间,然后与文本 prompt 拼接后输入 LLM 模型用于文本训练。文章中提到对于视觉特征到文本特征的转换方式可以使用 Blip 中的 Q-former 进一步提升效果。